De l'étranglement des données à l'innovation : Comment 'UNO' révolutionne la génération d'images par IA

Pourquoi les générateurs d'images traditionnels échouent dans le monde réel

Malgré les progrès récents de l'IA générative, une limitation flagrante demeure : la cohérence entre les sujets et les scènes. Demander à un modèle de créer un chat sur un skateboard ? Facile. Lui demander de conserver les mêmes caractéristiques, la même pose et la même tenue pour ce chat dans cinq nouveaux contextes ? C'est là que les choses se compliquent.

Cette défaillance provient de la dépendance de l'industrie à des ensembles de données appariées de haute qualité, mais rares. Sans eux, les modèles ne peuvent pas apprendre à générer des résultats visuellement cohérents avec un contrôle précis, en particulier pour les scènes multi-sujets ou les personnalisations spécifiques à l'utilisateur. C'est là que la plupart des systèmes échouent à évoluer, surtout dans les déploiements commerciaux.

L'idée révolutionnaire : Laisser le modèle améliorer ses propres données d'entraînement

L'équipe de recherche derrière “Less-to-More Generalization” inverse la tendance avec une idée astucieuse : et si le modèle pouvait générer ses propres données, puis en tirer des leçons ?

Leur solution proposée est un pipeline de "co-évolution modèle-données", où un modèle initial commence avec des scènes simples à sujet unique, génère ses propres données d'entraînement et évolue progressivement vers des configurations multi-sujets plus complexes. À chaque itération, la précision du modèle et la qualité des données s'améliorent, créant une boucle de rétroaction d'augmentation de la capacité.

Il ne s'agit pas seulement d'une modification de l'entraînement, mais d'un nouveau paradigme pour la construction de systèmes génératifs dans des environnements pauvres en données.

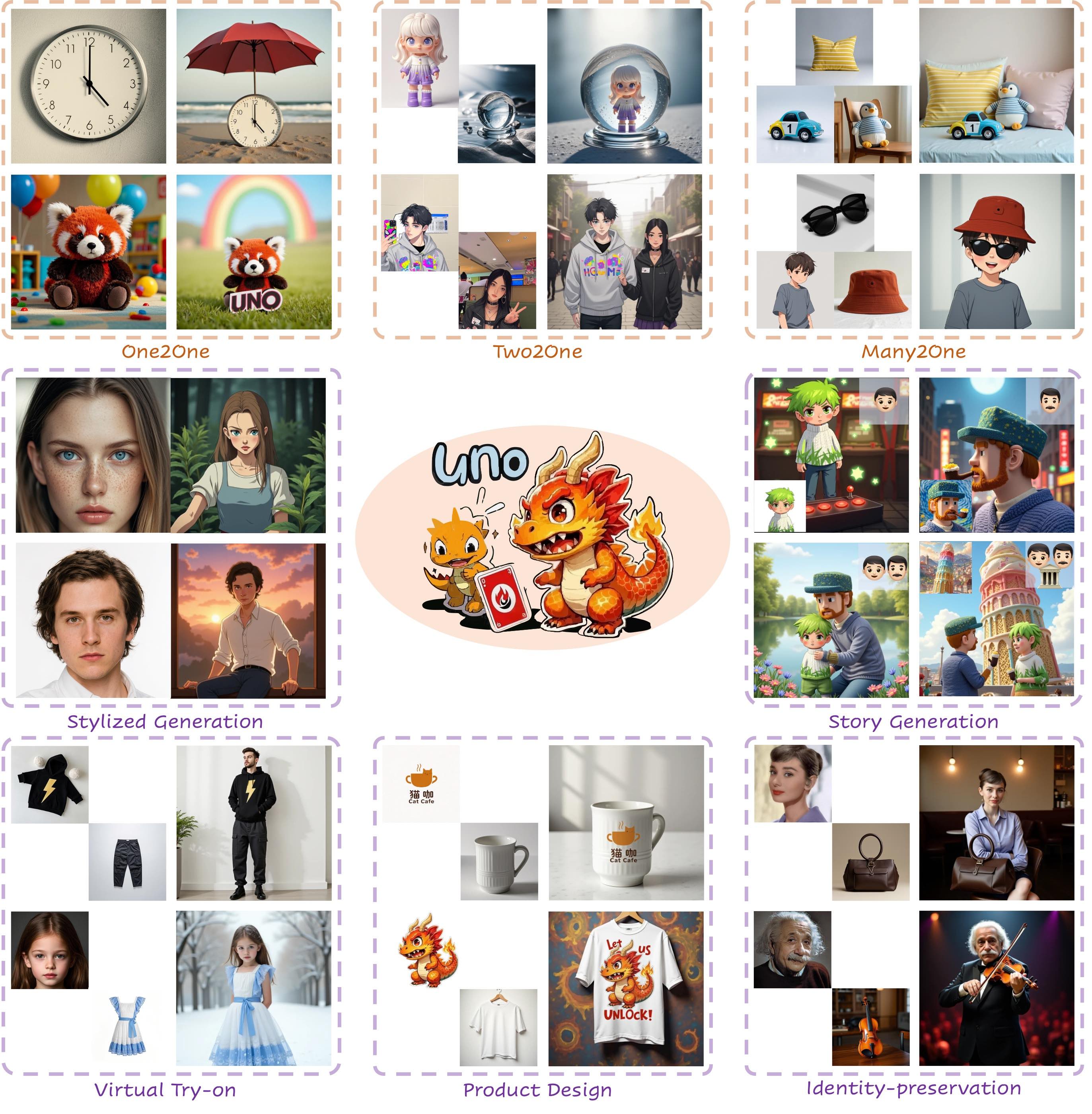

Voici UNO : Le modèle d'IA conçu pour une personnalisation de haute fidélité

UNO (abréviation de Universal Customization Network) est le moteur technique de ce changement de paradigme. Il s'agit d'une architecture conçue sur mesure, basée sur des transformateurs de diffusion et optimisée pour le contrôle visuel, l'alignement du texte et la cohérence de la composition.

🧠 Entraînement facile, évolution difficile : La stratégie d'apprentissage en deux étapes

UNO s'entraîne d'abord sur des scènes à sujet unique pour construire une base stable. Ce n'est qu'après avoir maîtrisé des tâches simples qu'il s'attaque aux compositions multi-sujets. Cette stratégie "du simple au complexe" empêche le système de s'effondrer sous une surcharge cognitive trop tôt dans l'entraînement, un problème qui a affecté d'autres modèles visuels à grande échelle.

🧪 Construire des données à partir de zéro, puis les filtrer comme un pro

UNO utilise un pipeline de conservation de données synthétiques, où il génère ses propres images haute résolution, appariées par sujet, à l'aide de modèles de diffusion. Mais toutes les données auto-générées ne sont pas égales. Un mécanisme de filtrage intelligent, alimenté par des modèles de vision-langage, élimine les incohérences et garantit que seules les meilleures paires d'entraînement sont conservées.

📐 UnoPE : Une solution spatiale à la confusion des attributs

Les scènes multi-sujets entraînent souvent des attributs mal assortis ou des identités fusionnées. UNO résout ce problème avec **Universal Rotary Position Embedding **—une méthode qui équilibre intelligemment les informations de mise en page des invites textuelles avec les caractéristiques visuelles des images de référence. Le résultat ? Des compositions propres où chaque sujet conserve son identité.

Performances d'UNO : Le nec plus ultra, à l'intérieur comme à l'extérieur

UNO n'est pas seulement une nouveauté technique, il étaye ses affirmations par des performances dominantes sur des benchmarks du monde réel.

- Surpasse les principaux modèles sur DreamBench, avec des scores DINO et CLIP-I de premier ordre dans les tâches de génération d'images à sujet unique et multi-sujets.

- Les études auprès des utilisateurs ont systématiquement préféré les résultats d'UNO pour des paramètres tels que la fidélité du sujet, l'attrait visuel et le respect des invites.

- Les tests d'ablation prouvent que chaque composant (génération de données, UnoPE et la stratégie intermodale) ajoute une valeur mesurable aux capacités du système.

Pour les entreprises à la recherche de solutions d'IA déployables, ce type de rigueur quantitative est important. Il signale la préparation à l'intégration commerciale, et pas seulement aux démonstrations en laboratoire.

6 marchés qui peuvent immédiatement profiter des capacités d'UNO

Les applications pratiques d'UNO couvrent de nombreux secteurs à forte croissance. Voici où il peut générer un retour sur investissement dès aujourd'hui :

🛍 Commerce électronique et essayage virtuel

Les détaillants en ligne peuvent utiliser UNO pour permettre aux clients d'essayer des vêtements ou des accessoires, sans séances photos ni modifications manuelles. La conservation cohérente du sujet garantit des résultats personnalisés sans perte d'identité.

🎨 Agences de design et de création

Des personnages numériques aux visuels publicitaires, les équipes créatives peuvent tirer parti d'UNO pour le prototypage rapide et les campagnes cohérentes avec la marque, tout en minimisant le travail manuel répétitif.

🚗 Visualisation de produits automobiles et industriels

UNO permet aux équipes de produits de rendre des visuels conceptuels avec un contrôle précis des caractéristiques. Cela réduit le temps nécessaire entre l'idéation et le prototype et diminue la dépendance aux maquettes photoréalistes.

📱 Plateformes de contenu personnalisé

Les applications proposant des avatars personnalisés, des histoires basées sur des personnages ou la génération de médias personnalisés peuvent utiliser UNO pour faire évoluer la génération de contenu tout en la gardant spécifique à l'utilisateur.

🧥 Fashion Tech et startups DTC

Les plateformes de mode personnalisée et de vente directe aux consommateurs peuvent utiliser UNO pour simuler des variations de vêtements sur différents modèles, offrant des lookbooks personnalisés et une personnalisation en temps réel.

🎬 Médias et divertissement

Des films d'animation au contenu interactif, la capacité d'UNO à maintenir la cohérence des personnages d'une scène à l'autre en fait un outil idéal pour les productions virtuelles et le story-boarding.

Ce qu'il faut surveiller : Trois risques à noter

Chaque avancée a ses compromis. Les investisseurs et les équipes d'entreprise doivent les évaluer attentivement :

1. Importantes exigences de calcul

L'entraînement d'UNO à grande échelle exige toujours des ressources GPU substantielles, ce qui rend l'adoption initiale coûteuse pour les petites équipes. Les pipelines basés sur le cloud peuvent atténuer ce problème, mais à un prix.

2. Biais dans la boucle de rétroaction synthétique

UNO s'appuie sur des modèles existants pour créer ses données synthétiques. Si ces modèles de base contiennent des biais latents, ils peuvent être amplifiés par l'auto-entraînement. Cela soulève des problèmes éthiques et de précision, en particulier dans les applications impliquant la ressemblance humaine ou la diversité culturelle.

3. Limitations spécifiques au domaine

UNO excelle dans l'imagerie générique et destinée au consommateur. Mais son efficacité dans les domaines très réglementés ou de niche (comme l'imagerie médicale ou les plans d'ingénierie) reste à valider. La personnalisation dans ces domaines nécessiterait des régimes d'entraînement spécifiques.

Un plan pour une IA générative évolutive et contrôlable

L'architecture d'UNO et la stratégie de co-évolution ne sont pas seulement des artefacts de recherche, ce sont des plans pour la prochaine génération de systèmes d'IA évolutifs et contrôlables. En permettant aux modèles d'améliorer itérativement leur propre environnement d'entraînement, Wu et son équipe ont créé une voie à suivre pour les applications d'IA qui exigent précision, personnalisation et performance.

Pour les chefs d'entreprise, cela ouvre une proposition puissante : la conception personnalisée à la vitesse du code.