Pourquoi SlowFast-LLaVA-1.5 Pourrait Être la Percée pour la Compréhension Vidéo Longue Durée – Sans Surcharge de Calcul

Le Véritable Goulot d'Étranglement du Traitement Vidéo par IA ? Les Tokens, Pas Seulement la Puissance de Calcul

Le contenu vidéo long format explose. Des images de surveillance aux conférences éducatives, le besoin d'extraire des informations pertinentes de vidéos de plusieurs minutes, voire plusieurs heures, n'a jamais été aussi grand. Mais pour l'IA, comprendre le contexte temporel à long terme dans la vidéo ne consiste pas simplement à ajouter plus d'images ou à affiner un modèle plus grand.

Le vrai défi ? L'efficacité des tokens.

La plupart des grands modèles de langage vidéo (Video LLM) existants ont du mal à évoluer. Ils traitent de grandes quantités de données, mais consomment énormément de puissance de calcul et de mémoire, ce qui les rend impraticables pour les déploiements mobiles, en périphérie ou même pour de nombreuses entreprises.

C'est là que SlowFast-LLaVA-1.5 entre en scène. Développée comme une solution économe en tokens et reproductible pour la compréhension vidéo longue durée, elle combine une nouvelle approche de traitement à deux flux avec un pipeline d'entraînement allégé, offrant des performances de pointe, même avec des modèles plus petits (jusqu'à 1 milliard de paramètres).

Pour les entreprises qui misent sur une IA évolutive et pour les investisseurs à la recherche de solutions d'IA déployables en périphérie, ce modèle représente un changement technique et stratégique significatif.

L'Architecture à Deux Flux Qui a Changé la Donne

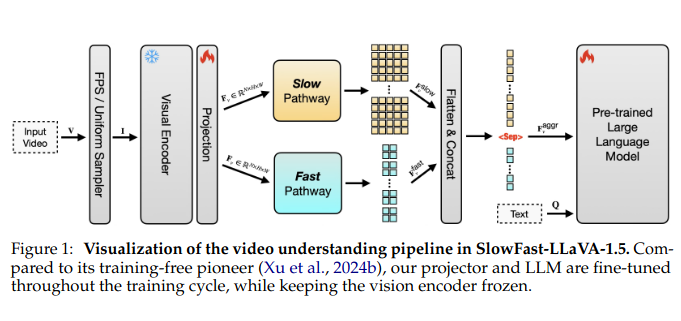

Au cœur de SlowFast-LLaVA-1.5 se trouve une astucieuse torsion architecturale empruntée et adaptée de travaux antérieurs en matière de reconnaissance vidéo : un mécanisme SlowFast. Voici comment cela fonctionne :

- Le flux lent (Slow stream) traite moins d'images à une résolution plus élevée, capturant des détails spatiaux riches à partir d'images clés sélectionnées.

- Le flux rapide (Fast stream) traite beaucoup plus d'images, mais avec moins de granularité, se concentrant sur le mouvement et le flux temporel.

En combinant ces voies et en agrégeant leurs sorties, le modèle capture à la fois ce qui se passe dans chaque image et la façon dont les scènes évoluent au fil du temps, sans se noyer dans les tokens.

Il s'agit d'un changement par rapport aux transformateurs vidéo monolithiques qui ont du mal à équilibrer la précision spatiale et la portée temporelle. Le résultat ? SlowFast-LLaVA-1.5 traite près de deux fois plus d'images en utilisant seulement 65 % des tokens par rapport aux autres modèles leaders.

Un Entraînement Plus Léger, Une Adoption Plus Large

L'entraînement de grands modèles vidéo est notoirement complexe, impliquant souvent des ensembles de données propriétaires, des pipelines à plusieurs étapes et un réglage gourmand en ressources. Les auteurs de SlowFast-LLaVA-1.5 ont adopté une approche plus pragmatique :

- Étape I – Affinage Image Seule : Le modèle est d'abord entraîné sur des ensembles de données d'images disponibles publiquement pour établir un ancrage visuel et un raisonnement général.

- Étape II – Entraînement Conjoint Vidéo-Image : Il est ensuite exposé à un ensemble organisé de données vidéo et d'images, permettant au modèle d'apprendre à la fois la dynamique spatiale et temporelle.

Les ensembles de données sont open source et l'approche est reproductible, deux attributs souvent absents des récentes versions de LLM. Cet accent mis sur l'accessibilité n'est pas seulement académique ; il abaisse la barrière à l'entrée pour les petites entreprises ou les startups qui cherchent à intégrer une IA vidéo avancée.

Des Benchmarks Qui Soutiennent l'Affirmation

Les mesures de performance ont été testées sur plusieurs benchmarks de premier plan, notamment :

- LongVideoBench : 62,5 % avec le modèle 7B

- MLVU (Multimodal Long Video Understanding) : 71,5 % avec le même modèle

Notamment, même les modèles à 1 et 3 milliards de paramètres ont donné des résultats compétitifs, prouvant que la taille n'est pas toujours le facteur de différenciation. C'est un atout particulièrement intéressant pour les entreprises qui explorent le déploiement mobile ou en périphérie.

De plus, grâce à sa stratégie d'entraînement conjointe, le modèle n'a pas sacrifié les capacités de raisonnement d'image. Il rivalise à égalité avec les modèles de langage d'image dédiés, un avantage clair pour le traitement multimodal unifié.

Efficacité Sans Compromis

En chiffres bruts, les gains d'efficacité sont clairs :

- Traite jusqu'à 2× le nombre d'images

- Utilise ~35 % moins de tokens que les modèles comparables

- Réduit considérablement les coûts de calcul tout en maintenant ou en dépassant les niveaux de performance

Cet équilibre entre précision et efficacité ouvre un plus large éventail de cas d'utilisation, des caméras intelligentes et des systèmes de surveillance IoT aux assistants vidéo intégrés aux applications ou aux outils d'exploration des connaissances d'entreprise.

Pour les investisseurs, cela signifie un retour sur investissement plus important et des barrières plus faibles à la commercialisation.

Valeur Stratégique Dans Tous les Secteurs

Intégration de l'IA en Entreprise : Grâce à sa taille compacte et à son architecture efficace, SlowFast-LLaVA-1.5 peut être déployé dans des environnements où la bande passante, la puissance de calcul et la latence sont des contraintes critiques, comme la surveillance sur site, l'analyse du comportement des clients dans le commerce de détail ou les diagnostics de machines sur le terrain.

Plateformes de Média et de Streaming : La synthèse automatisée, l'indexation de recherche et la modération de contenu pour les médias longs deviennent réalisables à moindre coût.

Technologie d'Assistance et Accessibilité : L'interprétation en temps réel de la vidéo pour les utilisateurs malvoyants devient plus viable lorsque le traitement ne nécessite pas une infrastructure à l'échelle du cloud.

Sécurité et Défense : Les drones et les systèmes de surveillance sur l'appareil bénéficient énormément de modèles plus petits qui peuvent analyser les flux en direct sans télécharger des gigaoctets de vidéo.

Limites et Opportunités Ouvertes

Les auteurs reconnaissent deux limites clés :

- Limites de l'Échantillonnage des Images : Bien que l'échantillonnage des images soit basé sur le FPS pour la plupart des cas d'utilisation, le modèle revient à un échantillonnage uniforme lorsque la longueur de la vidéo dépasse un seuil d'images défini, ce qui risque de manquer des moments critiques dans le contenu ultra-long.

- Encodeur de Vision Gelé : Pour préserver l'efficacité, l'encodeur de vision reste gelé pendant l'entraînement. Bien qu'efficace, l'affinage de ce module peut débloquer des performances plus élevées, mais à un coût de calcul plus important.

Ces contraintes indiquent les prochaines étapes logiques pour les versions futures : techniques d'échantillonnage adaptatives, réglage sélectif du module de vision et intégration d'architectures économes en mémoire.

Pourquoi C'est Important Pour l'Industrie

Le paradigme vision-langage évolue rapidement. Jusqu'à présent, la plupart des percées dans l'IA vidéo se sont appuyées sur la force brute : des modèles plus grands, des ensembles de données plus volumineux, plus de tokens.

SlowFast-LLaVA-1.5 offre une approche stratégiquement plus allégée. Ce n'est pas seulement un nouveau modèle, c'est un modèle directeur pour la façon dont une IA efficace peut faire évoluer la compréhension vidéo dans tous les secteurs sans surcharger l'infrastructure.

Il démontre que l'efficacité des tokens peut être aussi puissante que l'échelle des paramètres, un message que la communauté de recherche et l'écosystème commercial doivent prendre au sérieux.

Conclusion Pour les Investisseurs et les Constructeurs

Si votre feuille de route implique le traitement intelligent de la vidéo, que ce soit pour la technologie grand public, les applications industrielles ou l'analyse en temps réel, SlowFast-LLaVA-1.5 est un signal qu'une IA haute performance ne signifie pas forcément une IA coûteuse.

Pour le capital-risque, cela ouvre la porte au soutien de startups qui manquaient auparavant des ressources nécessaires pour entraîner ou exécuter des modèles vidéo massifs. Pour les constructeurs d'entreprise, c'est une chance de déployer une IA vidéo compétitive sans reconstruire toute votre pile d'infrastructure.